要构建能够与人类有效合作的人工智能系统,首先要有一个良好的人类行为模型。但人类在做决定时往往表现得不太理想。

这种特别难以建模的不合理性通常归结为计算约束。一个人不可能花几十年的时间去思考一个问题的理想解决方案。

麻省理工学院(MIT)和华盛顿大学(University of Washington)的研究人员开发了一种方法来模拟智能体(无论是人还是机器)的行为,这种方法可以解释未知的计算限制,这些限制可能会阻碍智能体解决问题的能力。

他们的模型可以通过观察智能体之前行为的一些痕迹,自动推断出智能体的计算约束。结果,一个智能体所谓的“推理预算”,可以用来预测智能体未来的行为。

在一篇新论文中,研究人员展示了他们的方法如何从先前的路线推断出某人的导航目标,并预测棋手在国际象棋比赛中的后续动作。他们的技术与另一种流行的决策建模方法相匹配或优于这种方法。

最终,这项工作可以帮助科学家教授人工智能系统人类的行为方式,从而使这些系统能够更好地对人类合作者做出反应。电气工程和计算机科学(EECS)研究生、该技术论文的主要作者阿瑟·保罗·雅各布(Athul Paul Jacob)说,能够理解人类的行为,然后从这种行为中推断出他们的目标,这可能会让人工智能助手变得更有用。

“如果我们知道一个人即将犯错误,看到他们之前的行为,人工智能代理可以介入并提供更好的方法来做到这一点。或者智能体可以适应人类合作者的弱点。能够模拟人类行为是构建真正能够帮助人类的人工智能代理的重要一步。”

Jacob与华盛顿大学助理教授Abhishek Gupta以及资深作者Jacob Andreas共同撰写了这篇论文,Jacob Andreas是EECS副教授,也是计算机科学与人工智能实验室(CSAIL)的成员。该研究将于5月7日至11日在奥地利维也纳举行的国际学习表征会议(ICLR 2024)上发表。

模仿行为

几十年来,研究人员一直在建立人类行为的计算模型。许多先前的方法试图通过向模型中添加噪声来解释次优决策。模型可能会让代理在95%的情况下做出正确的选择,而不是总是选择正确的选项。

然而,这些方法可能无法捕捉到这样一个事实,即人类并不总是以同样的方式表现出次优状态。

麻省理工学院的其他人也研究了面对次优决策时更有效的计划和推断目标的方法。

为了建立他们的模型,雅各布和他的合作者从之前对国际象棋选手的研究中获得了灵感。他们注意到,当玩家做出简单的动作时,他们在行动前花的思考时间更少,而在具有挑战性的比赛中,较强的玩家往往比较弱的玩家花更多的时间来计划。

雅各布说:“最终,我们发现计划的深度,或者人们思考问题的时间,是人类行为的一个很好的代表。”

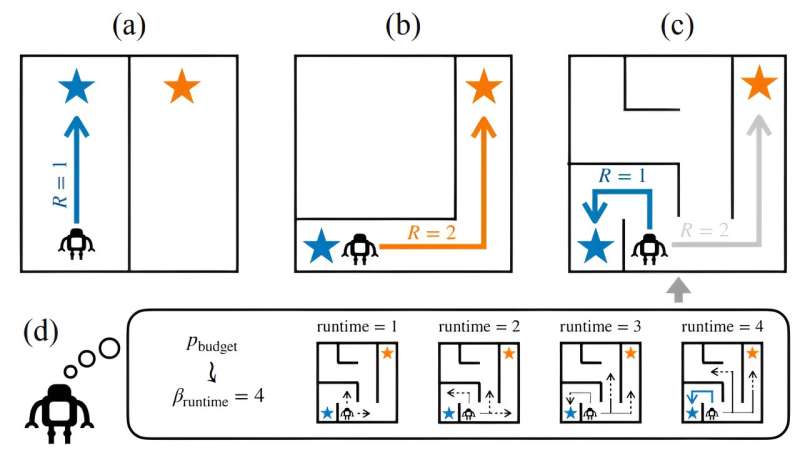

他们建立了一个框架,可以从先前的行动中推断出代理人的计划深度,并使用该信息来模拟代理人的决策过程。

他们的方法的第一步是在一段固定的时间内运行一个算法来解决正在研究的问题。例如,如果他们正在研究一场国际象棋比赛,他们可能会让下棋算法运行一定数量的步骤。最后,研究人员可以看到算法在每一步做出的决定。

他们的模型将这些决策与解决相同问题的代理的行为进行比较。它将使代理的决策与算法的决策保持一致,并识别代理停止计划的步骤。

由此,模型可以确定代理的推理预算,或者代理将为这个问题计划多长时间。它可以使用推理预算来预测代理在解决类似问题时会如何反应。

可解释的解决方案

这种方法非常有效,因为研究人员可以在不做任何额外工作的情况下访问由问题解决算法做出的全部决策。这个框架也可以应用于任何可以用特定算法类来解决的问题。

“对我来说,最引人注目的是这个推理预算是非常可解释的。它的意思是,更棘手的问题需要更多的计划,或者成为一个强大的玩家意味着要做更长的计划。当我们第一次开始这样做的时候,我们并不认为我们的算法能够自然地捕捉到这些行为,”雅各布说。

研究人员在三个不同的建模任务中测试了他们的方法:从以前的路线推断导航目标,从他们的语言线索猜测某人的交流意图,以及预测人类国际象棋比赛的后续动作。

在每个实验中,他们的方法要么与流行的替代方法相匹配,要么表现得更好。此外,研究人员发现,他们的人类行为模型与玩家技能(在国际象棋比赛中)和任务难度的测量结果非常吻合。

展望未来,研究人员希望使用这种方法来模拟其他领域的规划过程,例如强化学习(机器人技术中常用的一种试错方法)。从长远来看,他们打算继续在这项工作的基础上,朝着开发更有效的人工智能合作者的更大目标前进。

更多信息:用潜在推理预算建模有界理性智能体。openreview.net/pdf?id=W3VsHuga3j由麻省理工学院提供

本文由麻省理工学院新闻(web.mit.edu/newsoffice/)转载,这是一个报道麻省理工学院研究、创新和教学新闻的热门网站。

引用要创建一个更好的AI助手,首先要建模失衡 人类的nal behavior(2024, 4月19日)2024年4月19日检索自https://techxplore.com/news/2024-04-ai-helper-irrational-behavior-humans.html 作品受版权保护。除为私人学习或研究目的而进行的任何公平交易外,未经书面许可,不得转载任何部分。的有限公司 内容仅供参考之用。