我们使用计算机来帮助我们做出(希望)公正的决定。问题是,如果用于训练机器学习算法的数据中嵌入了人类的偏见,那么机器学习算法并不总是能做出公平的分类——这在实践中经常出现。

为了缓解这种“垃圾输入,垃圾输出”的情况,一个研究小组提出了一个灵活的框架来减轻机器分类中的偏见。他们的研究发表在《智能计算》杂志上。

根据该团队的说法,现有的减轻分类偏见的尝试往往受到依赖于特定的公平指标和预先确定的偏见条款的阻碍。团队的框架避免了这两种依赖;他们的偏见缓解可以在不同的公平指标下进行评估,他们从数据中推断出特定的偏见项。

该团队在21个机器分类器的7个数据集上评估了该框架。在整个实验中,分类结果的偏差大大减少,分类精度在很大程度上保持不变,在公平-效用权衡下工作良好。

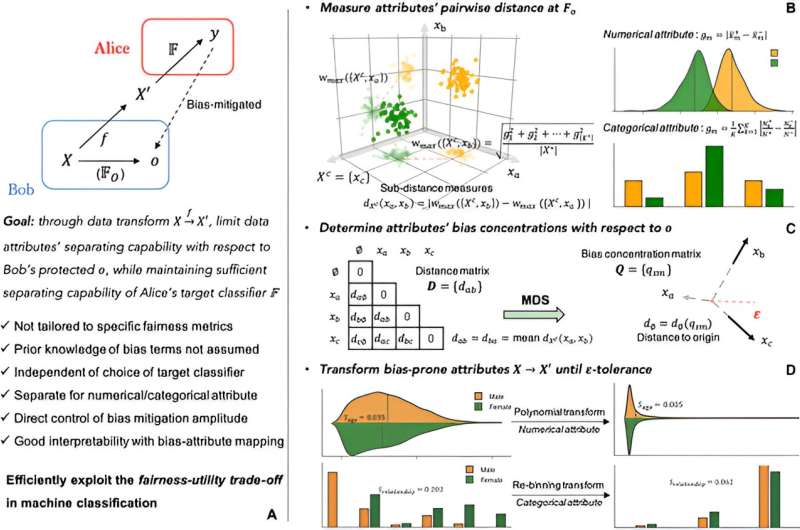

该框架共享对抗性去偏方法的设置,考虑到Alice(例如企业)和Bob(例如监管机构)之间的提议审查场景。Alice向Bob发送了一个建议,让Bob使用他的数据来开发一个目标分类器,比如一个大学匹配系统。

Bob审查了这个提议,目的是确保Alice的分类不会在一个敏感维度上表现出实质性的偏见,他的目的是保护这个敏感维度,比如学生的中学转学经历。我们的目标是构建一个分类器,它在受保护的维度上具有最小的区别,并且在目标分类中只牺牲很小的性能。

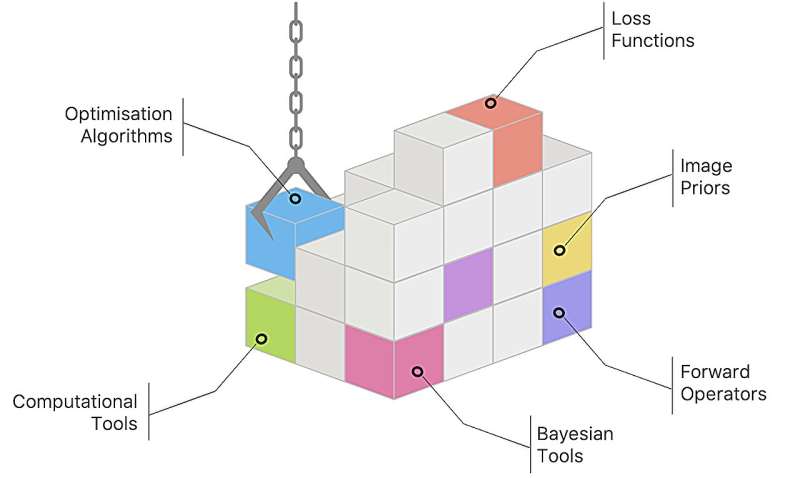

通过识别容易引入偏差的数据属性,然后对这些属性下的记录应用有效的数据转换,可以实现偏差缓解。

这包括评估属性对数据分离的贡献,计算属性之间的距离,并使用这些距离在构建的偏差超空间中建立偏差-属性映射。通过这种映射,可以推断出偏差项,识别出容易产生偏差的属性,并测量它们的偏差浓度。

然而,由于可扩展性的限制以及其他因素,工作流在应用于大型数据集时可能会遇到困难。

在未来的研究中,考虑到公共部门和私营部门之间的潜在冲突,该团队有兴趣扩展该框架,以直接在分类公平性和准确性之间取得平衡。从更广泛的角度来看,将行为特征纳入分类偏差缓解并分析此类框架应用中的实际设置是一个重要方向。

更多信息:唐周飞等,机器分类中非预定义偏差的度量独立缓解,智能计算(2024)。DOI: 10.34133 / icomputing.0083引文:新的缓解框架减少了分类结果中的偏差(2024,4月23日)检索自2024年4月24日https://techxplore.com/news/2024-04-mitigation-framework-bias-classification-outcomes.html本文档受版权保护。除为私人学习或研究目的而进行的任何公平交易外,未经书面许可,不得转载任何部分。内容仅供参考之用。