通过自动纠错和自动生成的电子邮件回复,算法为人们表达自我提供了大量帮助。

但乔治亚大学的一项新研究表明,那些依靠计算机算法帮助完成语言相关的创造性任务的人并没有提高他们的表现,而且更容易相信低质量的建议。

特里商学院(Terry College of Business)管理信息系统助理教授亚伦·谢克特(Aaron Schecter)在本月的《科学报告》(Scientific Reports)上发表了他的研究“在单词关联任务中,人类对算法建议的偏好”。他的合著者是宾夕法尼亚州立大学的生物行为健康助理教授Nina Lauharatanahirun,以及最近从特里学院博士毕业、现任东北大学助理教授的Eric Bogert。

这篇论文是该团队调查个人对算法生成的建议的信任的第二篇论文。在2021年4月的一篇论文中,该团队发现,人们在计算任务时更依赖算法建议,而不是据称由其他参与者给出的建议。

这项研究旨在测试人们在处理更具创造性和语言依赖性的任务时,是否会听从电脑的建议。该团队发现,参与者使用算法建议的可能性比接受人的建议的可能性高92.3%。

谢克特说:“这项任务不需要(与之前研究中的计数任务)相同类型的思维,但实际上我们看到了相同的偏见。”“他们仍然会使用算法的答案,并为此感到高兴,即使这并没有帮助他们做得更好。”

在单词关联过程中使用算法

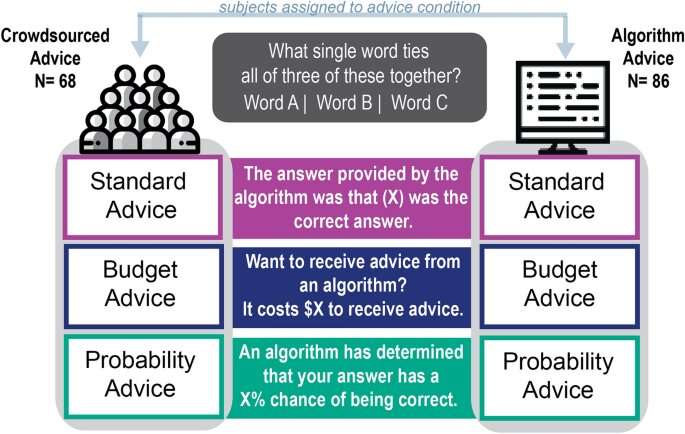

为了观察人们是否会更多地依赖计算机生成的建议来完成语言相关的任务,谢克特和他的合著者给154名在线参与者提供了远程联想测试(Remote Associates Test)的部分测试,这是一项用于评估参与者创造力的词汇联想测试,已有60年的历史。

他说:“这不是纯粹的创造力,但单词联想是一种与股票预测或计数照片中的物体完全不同的任务,因为它涉及语言学和联想不同想法的能力。”“我们认为这更主观,尽管这些问题都有正确答案。”

在测试中,参与者被要求想出一个单词将三个样本单词连接起来。例如,如果单词是base、room和bowling,那么答案就是ball。

参与者选择一个词来回答这个问题,然后得到一个由算法或某个人给出的提示,并允许他们改变答案。尽管问题的难度、建议的措辞方式或建议的质量如何,但人们对算法衍生建议的偏好非常强烈。

接受算法建议的参与者对答案的信心是接受建议的参与者的两倍。尽管他们对自己的答案很有信心,但他们选择正确答案的可能性比那些使用人工建议的人低13%。

他说:“我不会说这些建议让人们变得更糟,但他们并没有做得更好,却对自己的回答感觉更好,这就说明了问题的严重性。”“他们的信心上升了,所以他们可能会使用算法的建议,并感觉良好,但他们不一定是正确的。

写电子邮件时应该接受自动更正吗?

“如果我相信我的电子邮件有自动补全或自动更正功能,我可能不会考虑它是否让我变得更好。我只是想用它,因为我有信心这么做。”

谢切特和同事们把这种接受计算机生成的建议而不注意其质量的倾向称为自动化偏差。理解人类决策者如何以及为什么要听从机器学习软件来解决问题,是理解现代工作场所可能出现的问题以及如何补救的重要组成部分。

谢克特说:“通常当我们讨论是否可以让算法做决定时,让一个人参与决策是防止错误或坏结果的解决方案。”“但如果人们更倾向于听从算法的建议,这就不是解决方案。”