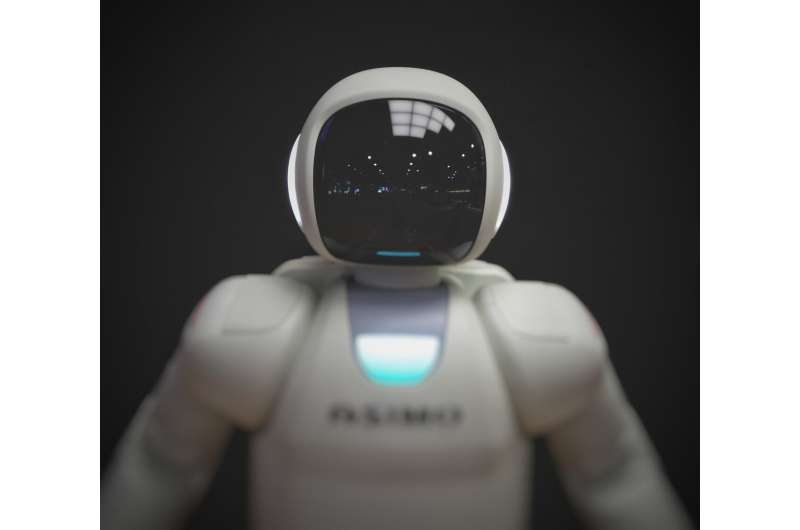

根据最近发表的一项研究,一个人对人类的不信任预示着他将更加信任人工智能调节在线内容的能力。研究人员表示,这些发现对社交媒体AI工具的设计者和用户都有实际意义。

宾夕法尼亚州立大学詹姆斯·p·吉米罗媒体效应教授s·希亚姆·桑达尔说:“我们发现了一个系统性的模式,那些不信任他人的人对人工智能的分类表现出了更大的信任。”“根据我们的分析,这似乎是因为用户认为机器是准确、客观、没有意识形态偏见的。”

这项发表在《新媒体与社会》杂志上的研究还发现,信息技术的资深用户“高级用户”的倾向恰恰相反。他们对人工智能审核员的信任降低了,因为他们认为机器缺乏检测人类语言细微差别的能力。

研究发现,在面对基于人工智能的内容审核系统时,用户会调用机器的正面或负面特征,从而最终影响他们对该系统的信任,这些个体差异如对他人的不信任和使用电量等可以预测。研究人员认为,基于个体差异的个性化界面可以积极地改变用户体验。研究中的内容审核类型包括监控社交媒体帖子中的问题内容,如仇恨言论和自杀想法。

“有些人可能不太相信内容审核技术,其中一个原因是我们习惯了在网上自由表达自己的观点。我们觉得内容审核可能会让我们失去这种感觉,”密歇根州立大学传播艺术与科学助理教授玛丽亚·d·莫利纳(Maria D. Molina)说,她也是这篇论文的第一作者。“这项研究可能为这个问题提供了一个解决方案,它表明,对于那些对人工智能的内容审核持负面刻板印象的人来说,在做出决定时加强人工参与是很重要的。另一方面,对于那些对机器有正面刻板印象的人来说,我们可以通过强调人工智能的准确性等元素来增强机器的优势。”

研究还发现,政治意识形态保守的用户更可能信任人工智能驱动的温和派。莫利纳和共同作者桑达尔(他也是宾夕法尼亚州立大学媒体效应研究实验室的联合主任)表示,这可能源于对主流媒体和社交媒体公司的不信任。

研究人员从美国招募了676名参与者。参与者被告知他们正在帮助测试一个正在开发中的内容审核系统。研究人员给了他们仇恨言论和自杀意念的定义,然后给了他们四个不同的社交媒体帖子中的一个。这些帖子要么被标记为符合这些定义,要么没有被标记。参与者还被告知,是否标记该帖子的决定是由人工智能、人类或两者的结合做出的。

演示之后是一份问卷,询问参与者的个体差异。差异包括不信任他人的倾向、政治意识形态、技术经验和对人工智能的信任。

莫利纳说:“我们受到了太多问题内容的轰炸,从错误信息到仇恨言论。”“但归根结底,这是关于我们如何帮助用户根据技术的实际属性校准他们对人工智能的信任,而不是被这些个体差异所左右。”

莫利纳和桑达表示,他们的研究结果可能有助于塑造未来人们对人工智能的接受程度。通过创建为用户定制的系统,设计师可以减轻怀疑和不信任,并建立对AI的适当依赖。

“这项研究的一个重要的实际意义是找出沟通和设计策略,帮助用户校准他们对自动化系统的信任,”Sundar说,他也是宾夕法尼亚州立大学社会责任人工智能中心的主任。“对AI技术过于信任的某些群体应该警惕它的局限性,而对那些不相信其调节内容能力的人应该充分了解人工参与过程的程度。”